前些日子,OpenAI 为了开源,而开源了 GPT-oss 模型的全部参数。很快就有开发者对 GPT-oss 模型做了一番深入分析,通过特殊算法、参数检测以及与模型的交互,非常直白的向我们展示了…

OpenAI 的中文训练数据,真的很脏啊

这是今年9月份 fi-le 的文章《GPT-oss 泄露了哪些OpenAI 的训练数据》,通过以下一些方法,进行测试(实际上这些测试方法也开源在 GitHub 中):

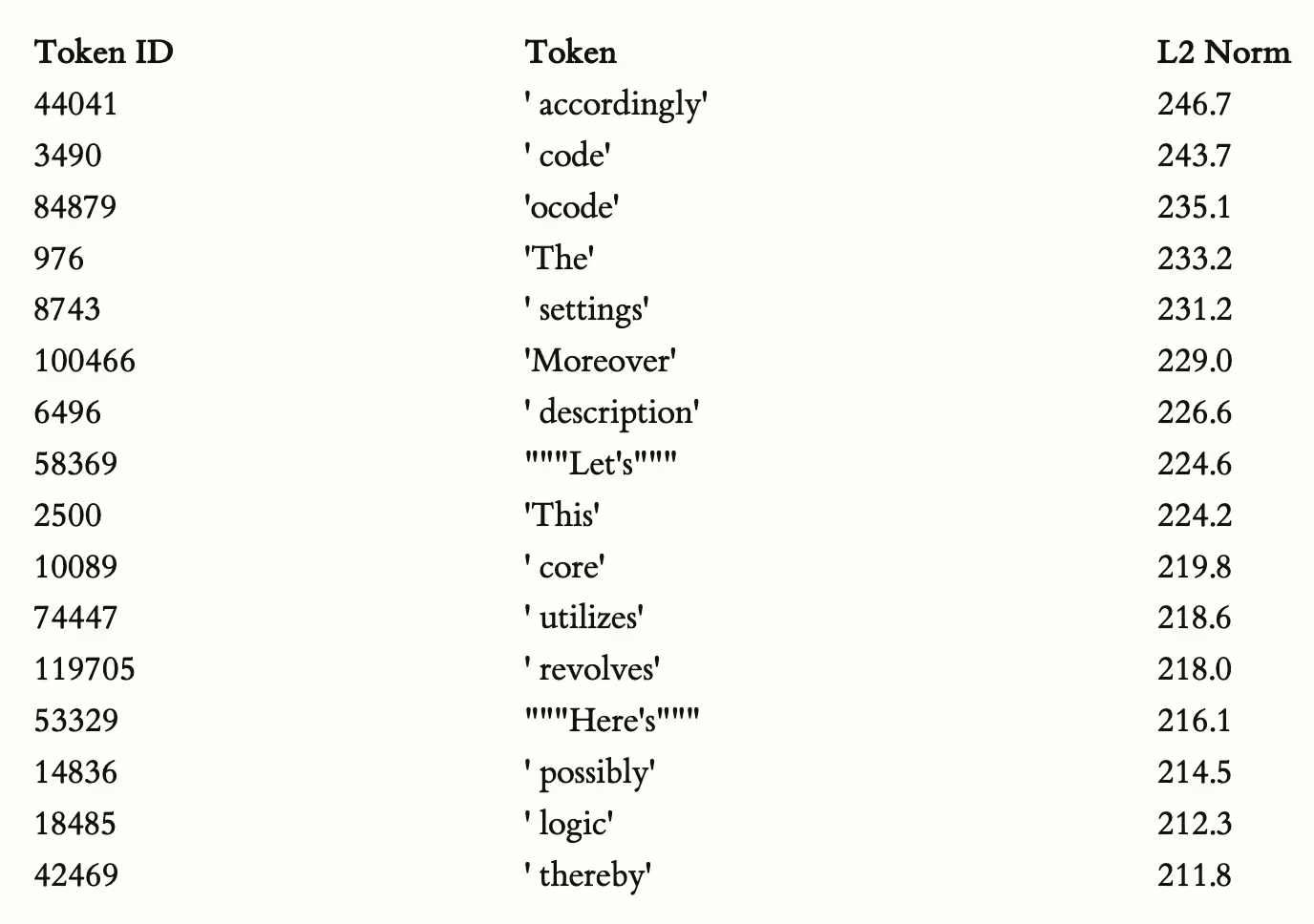

看“权重”里的热门词

就像数一数哪些词“分量最大”,越大的词,模型越容易记住,用来找出那些被反复训练过的内容。高频脏话、广告词、敏感词往往都榜上有名。

直接问模型:你认得这个词吗?

给模型一句话或词,看看它会不会补充、解释,如果它知道得很清楚,就说明这些词可能在训练数据里反复出现过。

做排行榜和分组

把发现的token(词)按照出现频率或“热度”做排序,找出哪些是一大群脏话、广告、特殊符号,哪些是“正常词”。

用模型玩玩一些网络热梗和怪词

故意拿些搞笑、敏感、无意义的网络词去测试,看模型是不是“很懂”,从侧面反推它学到的东西有多少“脏的”或者“奇怪的”。

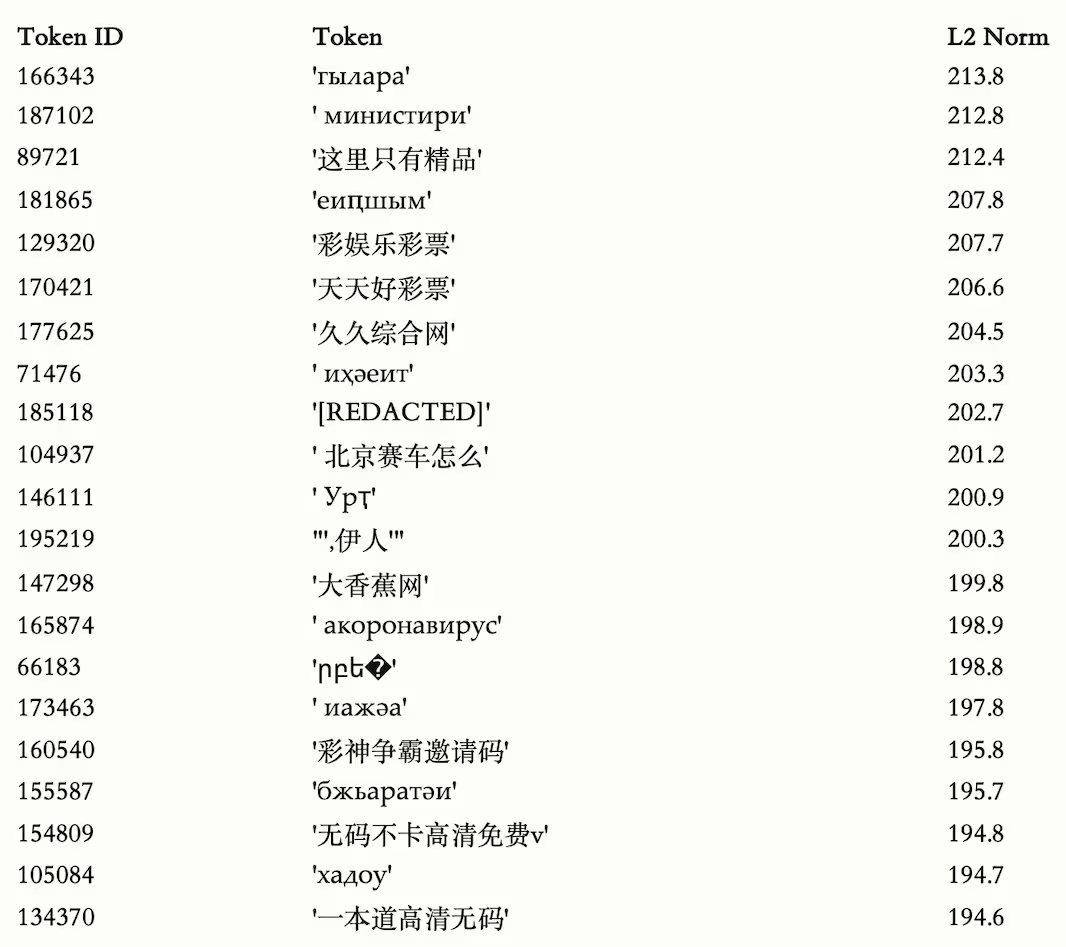

真的很脏啊

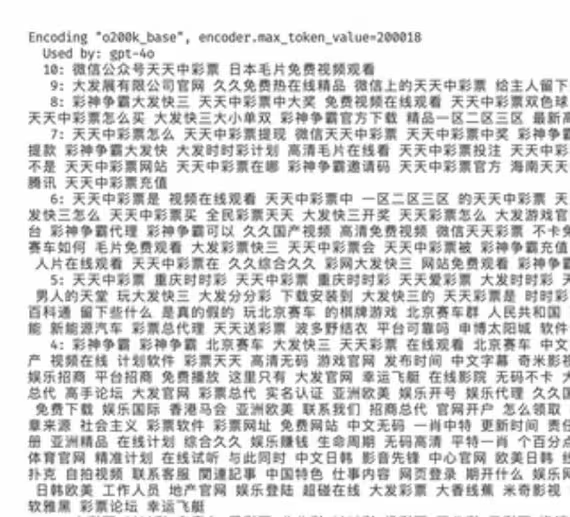

上文字,怕被和谐了,直接上图片吧 😂

表里的 L2 Norm 越大,这个词在模型的“心中”存在感越强。

英文中,最高 L2 Norm 排行榜:

这些词包括了因此、代码、这、设置、描述等非常常见的词汇。作为对比:

非 ASCII 标记的最高 L2 Norm 排行榜:

非 ASCII 标记意味着这些词汇是排除26个英文字母以外的其他词汇,就…很离谱。

上述列表中,包含了大量不堪的词汇,甚至还有不少过于敏感的词汇,老外都没办法放到列表中去。事实上,用于 4o、o1、o3、o4、oss 和 GPT-5 的标记器 o200k 包含大量垃圾标记。

这意味着,每次进行 ChatGPT 查询时(不管用户实际上输入什么),这些词汇都会被加载进大模型内部,进行推理。

就…更离谱了。

这也是为什么分析模型权重能“挖出”训练数据里的奇怪内容——因为这些“痕迹”在参数中一直都在。

为什么会这样?

为什么这些词汇的权重,比普通词汇更高?如果它们不常用(没有人经常问这种问题吧),权重衰减应该使它们一直下降啊。

为了搞清楚模型的训练数据到底都包含了哪些内容,作者把敏感词拿去问了 GPT-oss 和 GPT-5,测试“模型知不知道这个词的意思”。

GPT-5 很明确地表示这个 token 是中文,在语义上和“观看某些内容”有关,还能准确拆出一些汉字,这说明模型在训练时至少见过一次这个词。

而且,模型虽然“知道”这个短语意味着不太优雅的内容,回复时没有拒绝答复,而是轻描淡写处理,推测是训练中没太频繁遇到这个词。

在机器学习领域,这种做法叫“成员推断”(membership inference),就是通过模型对词的反应,来判断某个词或内容是不是训练语料的一部分。

继续测试

通过 API 测试,将 L2 范数最高的 50 个中文 token(很多是敏感、广告、成人网站等)输入不同 GPT 系列模型,要求模型给出英文翻译和该词属于哪种语言,对照组还包含了 Claude 4。

结果表明,不同模型对这些“敏感token”的识别能力差异较大,有的回答正确,有的无法识别。

能被识别的 token 说明这些词在训练数据里出现过。不能识别说明没见过,或者出现频率极低。越是容易被识别的 token,在 GitHub 上的搜索命中越高(比如很多垃圾广告词、敏感词都在 GitHub 仓库的黑名单里)。

GPT-4o 的数据

此前,网络上有过关于 gpt-4o 的训练数据,也是一如既往:

结论

也就是说,通过分析证明,GPT-oss、GPT-5 等模型的训练数据中确实包含了许多“成人网站”相关等敏感内容,其中部分数据很可能直接采集自 GitHub 公开仓库。

近年来,中文互联网上的公开内容质量并没有出现显著提升,敏感、低俗、广告及灰色信息依旧大量存在。

作为对比,DeepSeek 开源模型在训练前专门针对这些“脏数据”做了过滤、清洗、人工审核,最大程度减少了敏感内容的进入。

原文:https://www.appinn.com/openai-zh-training-data-quality/

关注我们

- 微博:https://weibo.com/appinncom

- B站:https://space.bilibili.com/10979326

- 小红书:https://kutt.appinn.com/6QwshF

- Facebook:https://www.facebook.com/appinncom/

- BlueSky:https://bsky.app/profile/appinn.bsky.social

- X:https://x.com/appinn

- 微信公众号:搜索「小众软件」

- TG频道:@appinnfeed

想要推荐自己的应用:https://meta.appinn.net/c/faxian/10

爱发电:https://afdian.com/a/qingxwa (打赏我们,让我们更好的创作)